一、引言

在 Java 编程的世界里,List 作为常用的数据容器,其灵活的存储与便捷的操作深受开发者喜爱。但在实际应用场景中,尤其是面对海量数据时,如何高效处理 List 中的元素成了关键问题。比如说,要将大量数据批量插入数据库,若一次性处理整个 List,不仅效率低下,还可能因数据库限制导致插入失败;又或者在前端分页展示数据时,后端需按固定数量从 List 中提取数据进行传输。这时候,将一个大的 List 分割成多个固定大小(每一千个元素)的子 List 就显得尤为重要,它能优化数据处理流程,提升程序性能。接下来,咱们就深入探讨 Java 中如何巧妙实现这一操作。

二、Java List 基础回顾

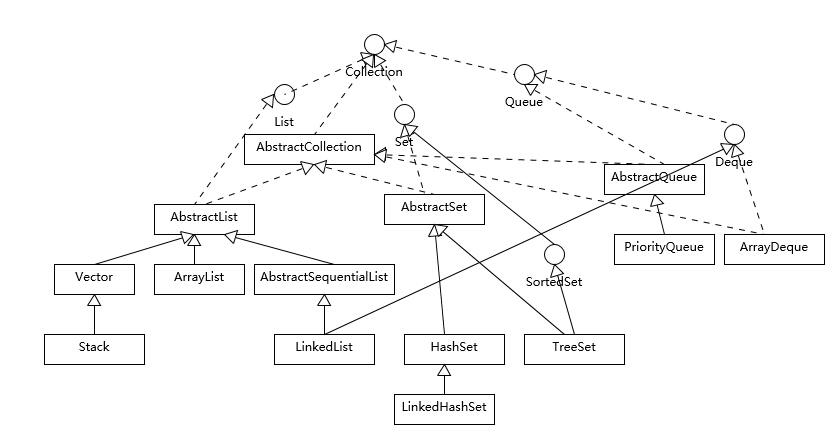

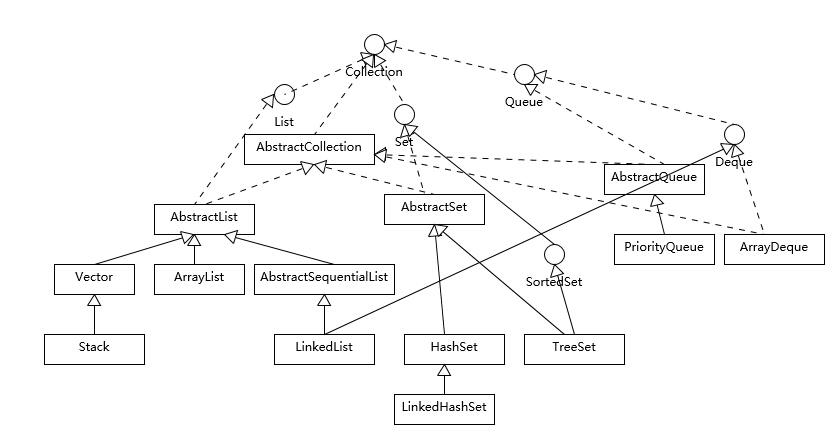

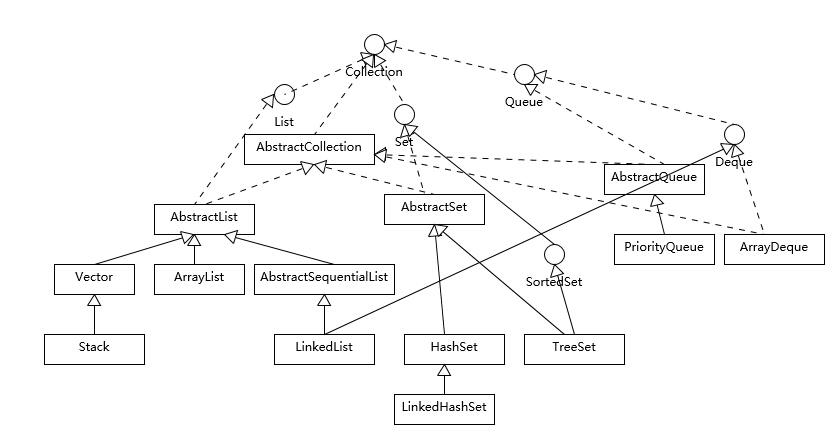

在深入探讨 List 分割之前,咱们先来热热身,回顾一下 Java List 的基础知识。List 作为 Java 集合框架中的一员,可是个相当重要的角色,它继承自 Collection 接口,最大的特点就是有序存储元素,并且允许元素重复,这就和 Set 集合形成了鲜明对比,Set 可是不允许有重复元素的哦。当我们创建一个 List 时,常用的实现类有 ArrayList 和 LinkedList。ArrayList 就像是一个动态数组,它基于数组实现,内存中元素连续存放,这使得它在随机访问元素时速度极快,通过索引就能迅速定位到想要的元素,时间复杂度为 O (1)。想象一下,在一个装满物品的有序箱子里找东西,只要知道物品的编号(索引),就能马上拿到,是不是很高效?不过,有利就有弊,ArrayList 在插入和删除元素时就有点 “力不从心” 了,尤其是在中间位置进行操作,因为要移动后续的元素,平均时间复杂度达到了 O (n)。好比在箱子中间插入或取出一个物品,后面的物品都得跟着挪动位置,很是麻烦。而 LinkedList 呢,它是基于双向链表实现的。每个节点不仅存储了数据,还包含指向前一个节点和后一个节点的引用,就像一条由节点串联起来的链子。这种结构让 LinkedList 在插入和删除元素时格外轻松,只需改变节点间的引用关系即可,时间复杂度为 O (1),不管是在表头、表尾还是中间位置操作,都能快速完成。但当要随机访问元素时,它就得从表头或表尾开始逐个遍历节点,直到找到目标元素,时间复杂度飙升至 O (n),就好比要在一条长长的链子上找特定的一环,得一个一个查看过去。了解了这些特性,我们就能根据实际需求灵活选择使用 ArrayList 还是 LinkedList。要是你的业务场景侧重于频繁的随机读取,像数据缓存、查询操作居多的情况,ArrayList 无疑是首选;而要是经常需要进行插入、删除操作,比如实现一个动态变化的队列,LinkedList 就更能派上用场啦。

三、分割需求剖析

为啥咱们要执着于每一千个元素一组来分割 List 呢?这背后可是大有学问。想象一下,你手头有一个超级庞大的 List,里面装着海量用户的信息,要是一股脑儿地对整个 List 进行操作,先不说效率高低,光是内存能不能吃得消都是个大问题。比如说,要把这些用户数据批量插入数据库,数据库一般对单次插入的数据量都有限制,一次性插入过多可能直接导致插入失败,程序崩溃。再比如,有些数据处理算法在处理大规模数据时,时间复杂度会随着数据量急剧上升,让程序运行得慢如蜗牛。将大 List 分割成每一千个元素一组的小 List,就好比把一个大工程拆分成一个个小项目。每个小 List 可以独立进行处理,咱们能灵活地控制处理进度,还能根据实际情况调整策略。在进行数据存储时,分批次地将这些小 List 对应的数据存入数据库,既能避免超出数据库的操作限制,又能在某批次插入失败时,精准定位问题,而不影响其他已经成功插入的数据。从资源利用角度看,一次只处理一千个元素,内存占用量相对稳定,不会出现因数据量过大而导致的内存溢出错误,程序运行起来更加稳健高效,为应对复杂的数据处理任务提供了有力保障。

四、实现方式大揭秘

(一)使用 subList 方法手动分割

Java 自带的 List 接口为我们提供了一个相当实用的方法 ——subList,它可是实现 List 分割的一把 “利器”。这个方法的原理其实并不复杂,它基于原 List 创建一个视图,返回的子 List 与原 List 共享内部存储结构,只是在访问时通过偏移量和长度来限定范围。在这段代码中,splitList方法通过循环,以指定的大小(这里是 1000)为步长,利用subList方法从原 List 中截取子 List,并添加到subLists中。最后在main方法里,我们可以看到分割后的子 List 被打印出来,呈现出每一千个元素一组的效果。这种方法的优点显而易见,它不需要引入额外的库,完全依赖 Java 标准库就能实现,非常轻便灵活,适用于各种简单的分割场景。不过,它也有一些小 “瑕疵”。由于返回的是原 List 的视图,这意味着如果不小心修改了子 List 中的元素,原 List 也会跟着改变,可能会引发一些意想不到的问题。而且,在处理边界情况时,比如原 List 的元素数量不是分割大小的整数倍时,需要格外小心,确保最后一个子 List 的范围正确,就像代码中使用Math.min来处理边界,避免越界异常。

(二)借助 Google Guava 框架

Google Guava 作为 Java 开发者的得力助手,为我们提供了简洁高效的集合操作工具。其中,Lists.partition方法简直是 List 分割的 “神器”。使用 Guava 之前,需要先在项目中引入依赖。如果是 Maven 项目,在pom.xml文件中添加如下配置:引入依赖后,来看看如何使用它进行 List 分割:短短几行代码,就轻松实现了将myList按每一千个元素一组进行分割。Lists.partition方法内部巧妙地处理了各种边界情况,返回的子 List 是独立的、不可变的视图,不会像subList方法那样存在修改子 List 影响原 List 的隐患,让代码更加健壮可靠。不过,“金无足赤”,Guava 虽好,但引入额外的依赖也意味着项目的体积会稍有增加,在一些对依赖库非常敏感、追求极致轻量化的项目中,可能需要谨慎权衡利弊。

(三)利用 Apache Commons Collections

Apache Commons Collections 同样是一个功能强大的工具库,为 Java 集合操作提供了诸多便利。其中的ListUtils.partition方法,在 List 分割领域也有着出色的表现。首先,要在项目中引入 Commons Collections 的依赖,对于 Maven 项目,在pom.xml文件里添加:引入之后,使用示例如下:在这个示例中,我们用ListUtils.partition轻松地将一个包含 10 个元素的 List 按照每 3 个元素一组进行了分割。这个方法的优势在于它的稳定性和兼容性,经过大量实践检验,能应对各种复杂的 List 场景。与subList方法相比,它返回的子 List 虽然也是原 List 的视图,但在一些细节处理上更加严谨,比如对于空 List 的处理更加规范,让开发者无需过多担心边界情况引发的异常,能更专注于业务逻辑的实现。综上所述,这三种方法各有千秋。在实际开发中,如果项目规模较小、追求简洁,subList方法手动分割或许就能满足需求;要是注重高效便捷、不介意引入额外依赖,Google Guava 的Lists.partition会是不错的选择;而对于那些对稳定性、兼容性要求极高,且已经在项目中广泛使用 Apache Commons Collections 的情况,ListUtils.partition无疑是可靠的方案。大家可以根据项目的具体情况,灵活选用合适的方法来实现 List 的精准分割,让 Java 编程之路更加顺畅。

五、代码实战演练

为了让大家更直观地感受上述几种方法的实际应用,咱们来一场代码实战演练。假设我们现在有一个存储整数的 List,里面包含了 10000 个元素,我们要将它按每一千个元素一组进行分割。首先是使用subList方法手动分割的完整代码:在这段代码中,splitList方法通过巧妙地运用循环和subList方法,实现了对任意类型的 List 按照指定大小进行分割。在main方法里,我们先构建了一个包含 10000 个整数的测试用 List,接着调用splitList方法完成分割,并将结果逐个子 List 打印出来,这样就能清晰地看到数据被成功分组。接下来是使用 Google Guava 框架的示例:这里,只需简单引入 Guava 库后,利用Lists.newArrayList快速创建测试 List,再调用Lists.partition就能轻松实现分割,代码简洁明了,而且得益于 Guava 内部完善的实现,无需担心边界等复杂问题。最后是 Apache Commons Collections 的使用范例:在这段代码中,借助 Apache Commons Collections 的ListUtils.partition,即使面对简单的测试数据,也能稳稳地完成分割任务,体现出其良好的兼容性与易用性。大家可以亲自将这些代码复制到本地环境运行试试,相信能对 Java List 的分割操作有更深刻的理解,以后在实际项目中遇到类似需求,就能信手拈来啦。

六、性能对比与优化建议

不同的 List 分割方法在性能上究竟有多大差异呢?咱们来一探究竟。当处理小规模数据时,比如几百个元素的 List,使用subList方法手动分割、Google Guava 的Lists.partition以及 Apache Commons Collections 的ListUtils.partition,这几种方法在执行速度上的差别可能并不明显,几乎都能瞬间完成分割任务,用户很难察觉到延迟。但一旦数据量飙升,达到数万甚至数百万级别,性能差异就逐渐凸显出来了。我们可以通过一个简单的测试来观察:构建一个包含百万整数的 ArrayList,分别使用上述三种方法按每一千个元素一组进行分割,并记录各自的耗时。在多次测试后发现,subList方法由于需要频繁地进行边界判断和视图创建,随着数据量增大,耗时呈明显上升趋势;Google Guava 的Lists.partition方法凭借其内部高效的算法实现,在大数据集下表现较为稳定,耗时相对较短;Apache Commons Collections 的ListUtils.partition同样有着不错的性能表现,接近 Guava,不过在一些极端情况下,细微的处理差异可能导致耗时稍多一点。基于这些性能表现,在实际项目优化时,如果你的项目对依赖库没有严格限制,优先选用 Google Guava 或 Apache Commons Collections 这类高性能的框架方法进行 List 分割,能为程序带来显著的性能提升,尤其是在处理海量数据的业务场景,像大数据分析、批量数据持久化等环节,节省的时间成本相当可观。另外,还有一个容易被忽视但很关键的优化点 —— 合理设置 List 的初始容量。以 ArrayList 为例,我们知道它在底层是基于数组实现的,当元素数量超过当前数组容量时,会触发扩容机制,而扩容过程涉及到数组的复制,是比较耗时的操作。如果我们能提前预估 List 的大致规模,在创建 ArrayList 时通过构造函数指定合适的初始容量,就能减少扩容次数,进一步提升性能。比如要存储一万个元素,事先知道这个量级,就可以使用new ArrayList<>(10000)来创建 List,避免多次不必要的扩容开销,让程序运行得更加流畅高效,轻松应对大数据挑战。

七、常见问题答疑

在进行 List 分割的过程中,大家可能会遇到一些让人头疼的问题,别担心,咱们一起来把它们解决掉。首先是索引越界异常(IndexOutOfBoundsException),这是个比较常见的 “小怪兽”。比如说,使用subList方法手动分割时,如果在计算子 List 的结束索引时不小心,就容易触发这个异常。像下面这段错误代码:在这个例子中,当循环到最后一次,i = 9时,i + 3 = 12,超出了myList的大小,就会导致索引越界异常。解决办法其实很简单,在获取子 List 时,像之前介绍的那样,使用Math.min来确保结束索引不会超出列表范围,修改后的代码如下:这样就能稳稳地避开索引越界的陷阱啦。再来说说空指针异常(NullPointerException),这个问题也不容小觑。当我们的 List 本身为null,或者 List 中的元素存在null值,并且在分割后操作子 List 时没有进行空值判断,就可能会触发空指针异常。要解决这个问题,在分割 List 之前,一定要先对原 List 进行非空判断,像这样:通过这样的空值判断,就能提前预防空指针异常,让程序更加健壮。希望大家在遇到这些问题时,能想起这些解决办法,轻松 “打怪升级”,顺利完成 List 的分割任务。

八、总结与拓展

咱们今儿个一起深入探讨了 Java 中 List 分割成每一千个元素一组的多种方法,从基础的 List 知识回顾,到剖析分割需求的根源,再到详细揭秘subList、Google Guava、Apache Commons Collections 等实现方式,实战演练让代码 “动” 起来,还对比了性能、解决了常见问题。重点就是要依据项目实际场景,像考虑数据量大小、是否介意引入额外依赖、对稳定性的要求等因素,来灵活挑选合适的分割策略。希望大家看完这篇文章后,别光纸上谈兵,赶紧把这些方法运用到自己手头的项目里试试,代码敲多了,自然就融会贯通啦。要是在实践过程中遇到新问题,或者有独特的见解、优化思路,欢迎随时在评论区分享交流,咱们一起抱团成长。后续呢,大家还可以进一步探索,要是不按固定数量,而是根据特定条件,像根据元素的属性值范围来分割 List,又该咋整?还有,在多线程环境下,如何巧妙结合这些分割方法,让数据处理效率坐上 “火箭”,飞速提升,都是值得深入钻研的方向,一起加油,向着 Java 编程的更高峰攀登!